4 周博磊RL-2-MDP

基础

- 马尔可夫过程,马尔科夫性

- 马尔可夫链

- 马尔科夫奖励过程,MRP=马尔科夫链+奖励函数

一些定义

- Horizon, episode的长度

- return, reward的折扣累积和

- 值函数, 当前状态未来期望累积奖励

为什么使用折扣因子:

- 避免马尔科夫链存在环时陷入死循环

- 表示未来的不确定性

- 当有立即回报时, 表示对较近的未来更感兴趣

- 人或动物更关注即时奖励

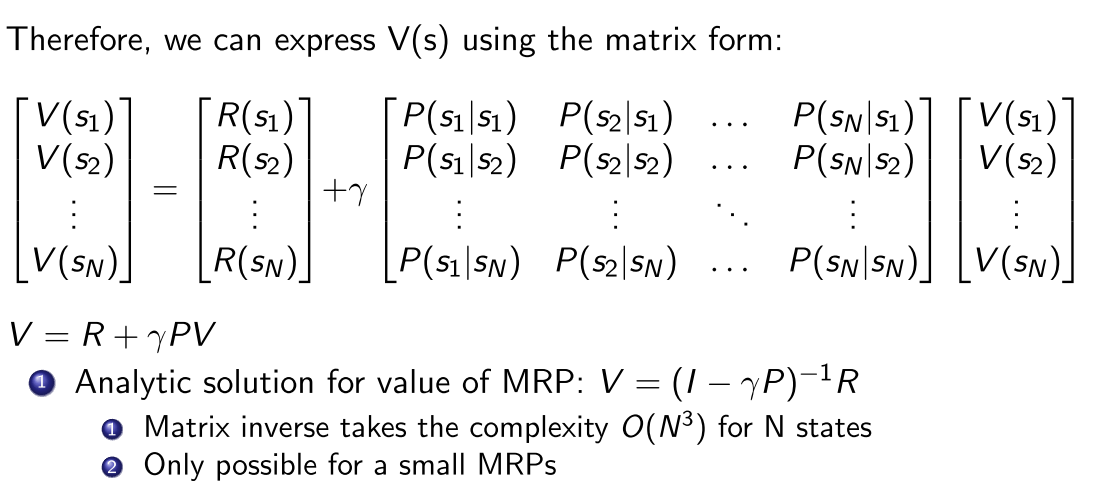

MRP的状态值函数

- 状态的Bellman方程,

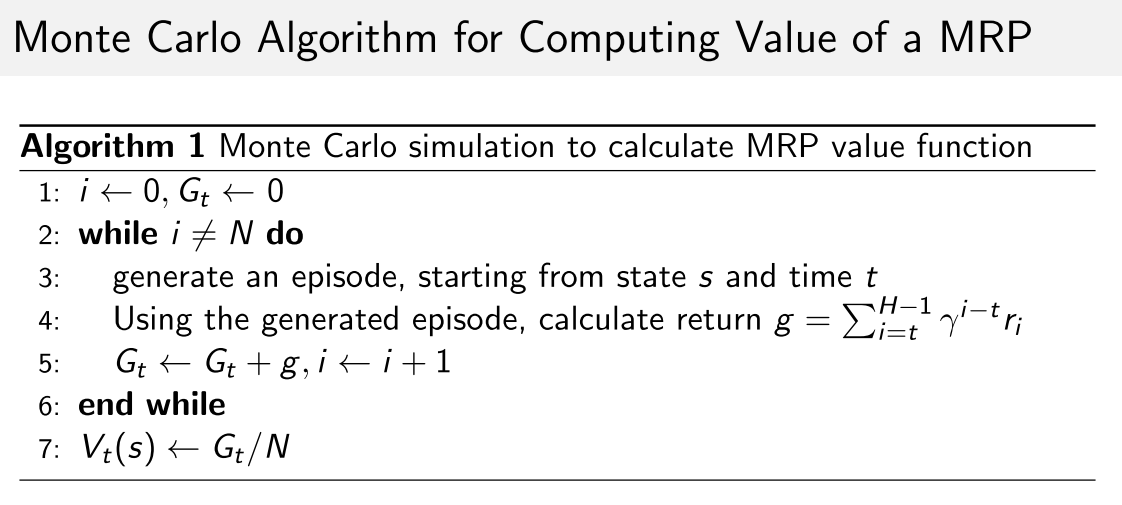

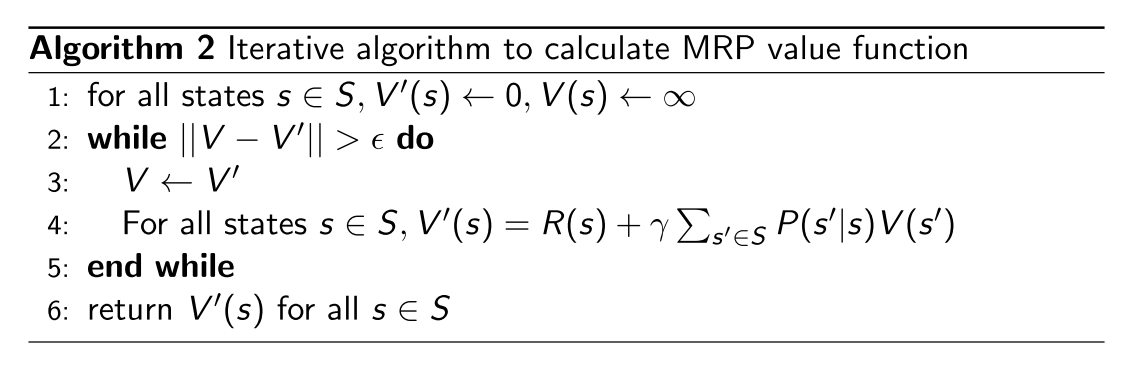

计算MRP值函数方法:

- DP

- MC

- TD

例子

MDP

- MRP->MDP

- 贝尔曼期望方程,贝尔曼最优方程

- 预测和控制

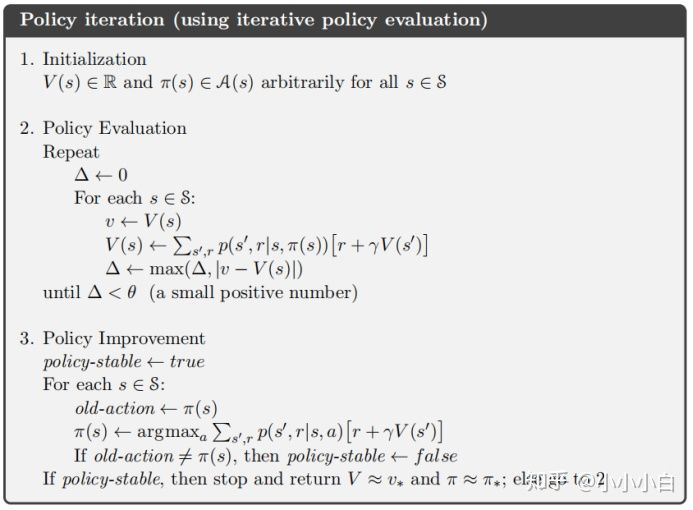

- 策略迭代, 策略估计-策略提升

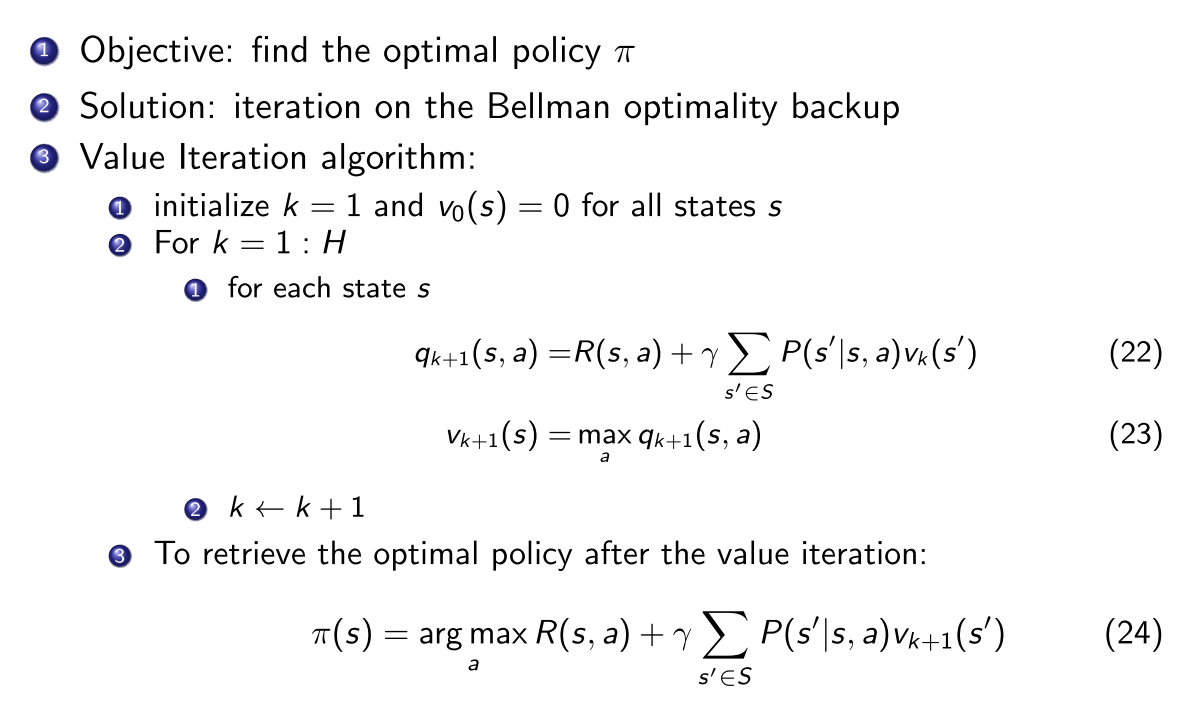

值迭代

总结

- 值迭代, 计算量少,收敛慢,贝尔曼最优方程, DQN

策略迭代,计算量大,收敛快,贝尔曼期望方程

- 策略估计, 贝尔曼期望方程迭代计算值函数, 直到收敛到局部最优

- 策略提升, 对值函数取argmax得到每个状态的当前最优策略