4 周博磊RL-10-总结

MDP

- 策略, 值函数, model

- 贝尔曼期望方程, 贝尔曼最优方程

- 评估, 控制, 策略评估与策略提升

- model-base/ model-free

- 值迭代/策略迭代, on/off-policy

DP/MC/TD

SARSA: On-policy

- 从Q导出动作, 并执行

- 也是从Q中导出的

- 使用贝尔曼期望方程更新

- Q-learning:Off-policy

- 从Q导出动作, 并执行

- 是用argmaxQ求出的, 没有实际执行, 是想象出来的

- 使用贝尔曼最优方程更新

值函数逼近

- MC, TD

- Q-learning/ DQN

策略优化

- 直接简单, 收敛性好, 随机策略

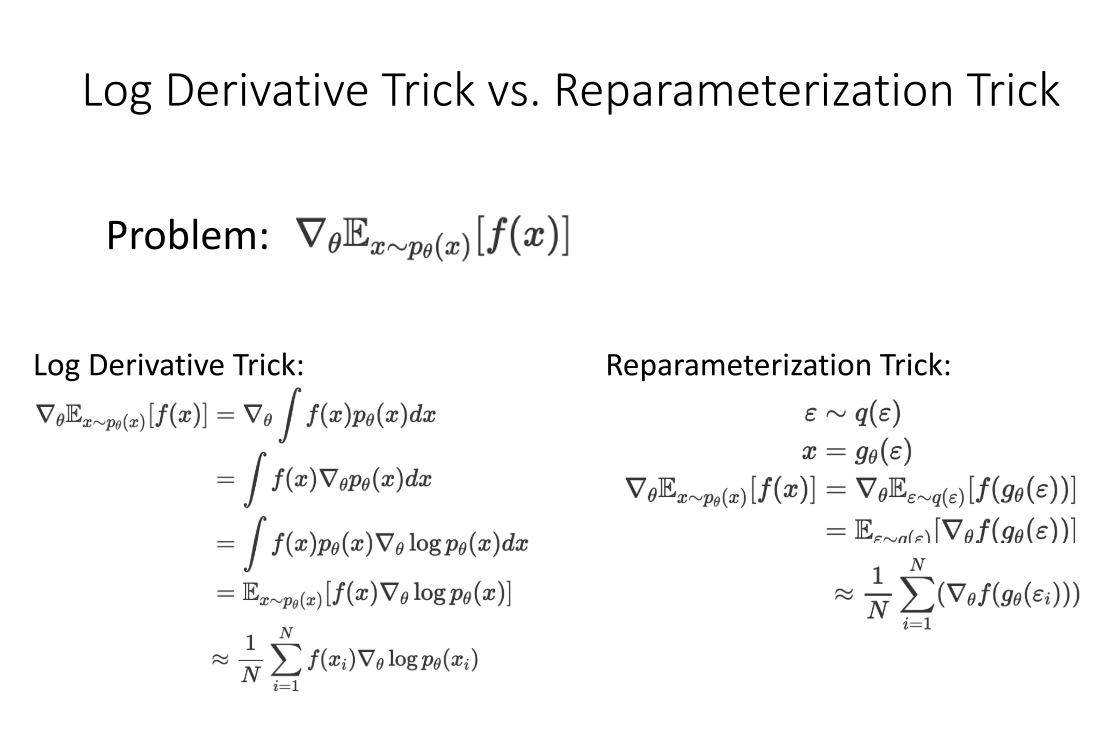

- log求导技巧, 重要性采样

- REINFORCE: 基于MC的PG算法

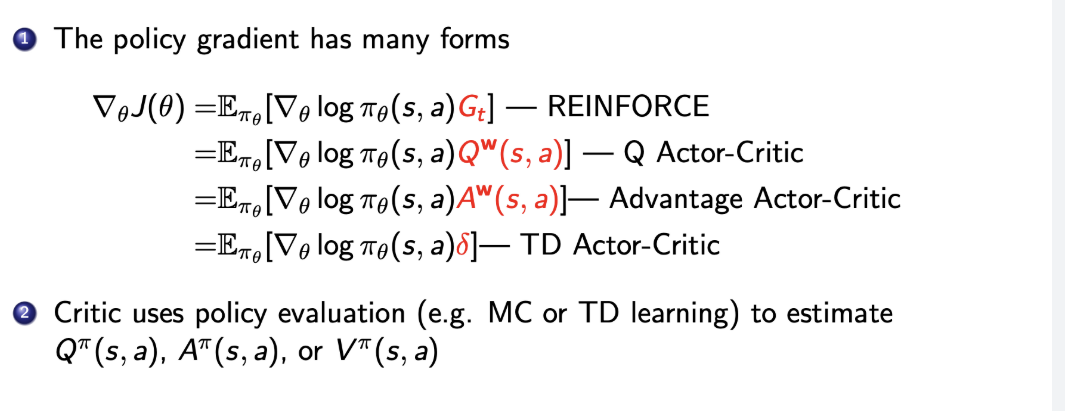

- 使用critic降低方差: QAC, AAC

SOTA算法

- PG--> Natrual PG/TRPO--> ACKTR-->PPO

- Q-learning --> DDPG --> TD3 --> SAC

Log Derivative Trick vs. Reparameterization Trick

高阶RL

- model-based RL

- 基于value的, 基于policy的

- IL+RL

- 预训练+微调

- off-policy

- IL 作为辅助损失

- 分布式RL system

- 数据并行, 模型并行

- DQN, GORILA, A3C, A2C, Apex-X, IMPALA, RLlib

未解决的问题

- Sample efficiency

- 通用RL

- 多任务

- 少先验

- 新环境设计, 新智能体

- RL中引入ML的方向:

- 预测模型

- 生成模型

- 元学习和多任务学习